博古睿讲座05 | 厘清人工智能规则与技术责任界限是关键

主要观点:全球范围内的技术法规和标准,与人工智能实际应用之间存在差距,“先斩后奏”模式等传统做法已不能支持人工智能发挥优势。不应由人工智能为其所造成的负面后果负责,而应由设计者承担责任。因此,应该在技术设计阶段积极主动规划,并植入尽可能充分的控制。

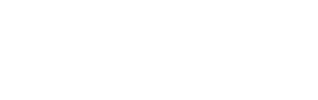

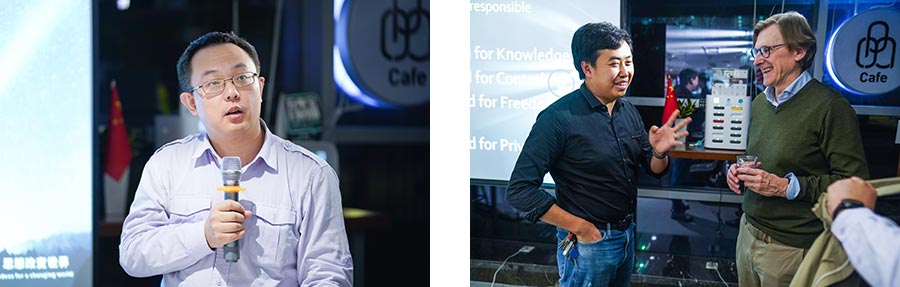

2019年11月1日,“博古睿讲座05:人工智能伦理:为责任而设计”在北京大学举办。由于我们在“人类应当如何建立与人工智能之间的关系”这个问题上存在较大分歧,讲座主题便将重点落在为何“负责任地设计人工智能”必须成为人工智能创新中不可或缺的组成部分。主讲人范德霍文(Jeroen van den Hoven)是荷兰伦理学家、代尔夫特理工大学哲学教授、《伦理学和信息技术》(由施普林格·自然集团出版)主编,目前担任荷兰代尔夫特设计价值研究所科学主任;讲座由北京大学哲学系助理教授李麒麟主持。

开场环节,范德霍文向听众展示了全球范围内诸多技术法规、原则和标准,与人工智能实际开发利用之间存在的差距。他指出,“先斩后奏”模式在安全性上存在着较大隐患,这类传统做法已然不能支持人工智能更好地发挥其优越性。“厘清责任界限在弥合规则与技术的鸿沟方面具有重要作用,伦理学家与工程师在这一方面的作用具有许多共通点”,范德霍文说到。

范德霍文在发言中明确表示,不应由人工智能本身来为其所造成的意外或负面后果负责,这一责任应由人工智能的设计者承担。他举了两个例子:一个是“弗兰肯斯坦”——受到指责与惩罚的对象不应是弗兰肯斯坦创造的怪物,而应当是弗兰肯斯坦博士本人。另一个是,范德霍文认为“人工智能应对其自身的犯罪行为负责”的观点,与11世纪欧洲教会判决人造物和物件有罪,以及18世纪欧洲判处动物有罪等荒谬举措如出一辙。他强调,现代人不应被这种过时的、不合理的思维所束缚。

那么,现代社会应当如何有效地思考“负责任地设计人工智能”这一问题呢?

范德霍文认为,我们不应一再重复“如果人工智能表现出人类特征将会如何”等“被动”的问题,而应在技术设计阶段就积极主动规划,并植入尽可能充分的控制。著名的电车难题表明了工程师和哲学家在思维方式上的区别:工程师会说可以开发一种制动系统来阻止火车陷入假设中的危险境地,而哲学家则会因为工程师未能从思维实验的角度理解这一经典难题而感到恼怒。

随着智能城市的出现,人工智能将得到大规模、多领域的普及,这一趋势引起了范德霍文对“二级责任”或是“让人们为他人的责任担责”等问题的思考。他比较了人工智能与核能的发展,来证明“二级责任”的重要性。在核能领域,不仅是首席科学家,就连负责运输建筑材料的后勤人员、盖革计数器的制造商,甚至保安人员都有义务对核能的安全性负责。他呼吁大家以同样的方式思考人工智能,并不是只有算法才重要。除核能外,航空、食品、制药和水工业也制定了无数相关法规;这些标准化举措取决于社会以及相关领域内部,如何理解“二级责任”这一命题。

随后,范德霍文讨论了规范背景对于合理界定人工智能责任的重要性。由于(从医疗到武器)人工智能用途各异,相关法规的范围必须足够灵活、健全,同时兼顾道德和治理领域。在深入研究社会应如何设计人工智能以防有人逃避责任之前,他梳理了目前主要存在的四种反对为行为担责的“借口”。第一是“知识”:因为一无所知,所以无法承担责任;第二是“控制”:因为无法控制环境,所以无法承担责任;第三是“自由和选择”:因为别无选择,所以无法承担责任;第四是“隐私和道德能力”:因未处于私人场合且只能根据公共利益来采取行动,所以无法承担责任。

讲座上,范德霍文数次强调多学科融合在“负责任设计人工智能”上的重要性。他认为,多学科视野、方法与知识的交融互通,有利于在人工智能时代增进人类知识、提高环境控制能力,同时更好地维护个人权益和保护隐私。

* 本文内容由北京大学博古睿研究中心秋季实习生、北京大学燕京学堂在读研究生李康圭(Kangkyu Lee)采写。

(杨嘉琪/编辑)

简介

活动主办方:

博古睿研究院中国中心

机构

活动时间:

2019-11-01

活动地点:

北京大学

活动状态:

已结束

视频